Article rédigé par Pierre Labrousse, le 02 décembre 2015

ETUDE | Le sommet de la COP21 ambitionne de limiter à 2°C la hausse de la température sur Terre d’ici à la fin du siècle. Les négociateurs s'appuient sur un diagnostic substituant à la complexité du climat une simplification qui, en incriminant le CO2, institue un processus dont la politique humaine aurait la maîtrise. Si tout engagement politique coûteux — on parle de 100 milliards de dollars par an — a besoin de certitudes, la science a besoin de libre discussion critique. Or celle-ci est écartée. Pourquoi ?

QU'EN EST-IL DE L'IMPACT de l’activité humaine sur notre environnement ? Comment l’apprécier en vérité et objectivité ? Ces questions sont liées à trois types de discours : 1/ la science qui décrit des phénomènes complexes, 2/ la politique qui doit gouverner pour l’avenir, 3/ l’interface entre les deux, qui est la représentation des conclusions scientifiques par les médias, représentation qui forge l’opinion et pour ainsi dire un « inconscient collectif ». Or la science témoigne toujours de la complexité tandis que les médias et les politiques ont besoin d’idées plus simples (I). Jusqu’où la simplification du complexe peut-elle légitimement aller ? (II) Comment se produit le réchauffement climatique et qu’en disent les scientifiques ? (III)

Commençons par étudier comment fonctionne le rapport entre science et politique : ce qu’on appelle le « principe de précaution »

I- Le principe de précaution

Gouverner, c’est prévoir, dit l’adage de la sagesse populaire. Or aujourd’hui, les avancées de la science et de la technique induisent dans le monde à venir des changements qu’il faut anticiper pour voir quels d’entre eux sont dangereux afin d’agir avant qu’il ne soit trop tard. Nos devoirs moraux ne concernent pas seulement nos contemporains, mais les générations futures et, par extension, tous les êtres qui seront indispensables à la vie de nos descendants.

Dans Le Principe responsabilité, Hans Jonas proposait déjà en 1979 une application environnementale de l’impératif catégorique kantien : « Agis de façon que les effets de ton action soient compatibles avec la permanence d'une vie authentiquement humaine sur terre. »

La vertu de prudence et la proportionnalité

Le « principe de précaution » est une application de la vertu de prudence. En résumant Aristote, la prudence consiste à inventer, organiser et mettre concrètement en œuvre les moyens efficaces et proportionnés permettant d’arriver à une fin juste. L’efficacité est une question d’intelligence pratique, d’inventivité pragmatique et technique. Mais la question de la proportionnalité est une question morale : la valeur de la fin poursuivie justifie l’ampleur des moyens consentis pour l’obtenir. Négliger les moyens revient à être injuste envers les êtres qui risquent d’être privés du bien recherché.

L’action vertueuse se définit notamment comme un juste milieu entre deux extrêmes, l’un par défaut, l’autre par excès. Ici ce juste milieu se situe entre un défaut de moyens où notre négligence risquerait de priver les gens d’un bien important, et un excès de moyens consentis (à éviter tel risque) risquant de manquer pour d’autres biens nécessaires. De là l’importance de la notion de proportionnalité qui est elle-même liée à l’évaluation du degré de gravité du mal à éviter, du degré de probabilité de son avènement, et enfin de l’efficacité escomptée de l’action à engager.

Si les moyens sont insuffisants, nous sommes injustes envers tous ceux à qui ce manquement risque d’être dommageable. Mais de même si les moyens sont excessifs : par exemple les millions d’euros consacrés par Roselyne Bachelot (alors ministre de la Santé) à l’achat de 100 millions de vaccins contre la grippe A auraient été plus utiles ailleurs. Dans ce cas, le gouvernement fut imprudent par excès disproportionnés de moyens. La notion de proportionnalité joue dans les deux sens : éviter une action insuffisante, éviter aussi une action trop importante, trop coûteuse qui lèse forcément d’autres actions pour autant que les ressources des États ne sont pas infinies.

En synthèse, le principe de précaution est une évaluation prudentielle qui s’inscrit dans la recherche du juste. Ainsi comme dans une balance, les deux côté doivent s’équilibrer. D’un côté, il y a le mal à éviter. On doit en évaluer trois aspects : sa gravité, son degré de probabilité, son évitabilité, autrement dit nos chances de l’éviter en mettant en œuvre telles actions préventives. De l’autre côté, il y a le coût de cette action : coût en argent, en ressources naturelles, en dégradation de la qualité de vie des humains et des autres espèces.

L’évaluation du risque de catastrophe

Or dans les questions d’environnement, la difficulté se trouve dans l’évaluation de la gravité d’une catastrophe non encore survenue et dans son niveau d’incertitude. Si on attend d’être sûr, alors on n’agira que lorsqu’il sera trop tard. Comment donc évaluer la gravité et la probabilité d’un mal qui ne s’est pas encore produit ? C’est le problème du lien entre incertitude et proportionnalité.

La loi Barnier de 1995 disposait que « l'absence de certitudes, compte tenu des connaissances scientifiques et techniques du moment, ne doit pas retarder l'adoption de mesures effectives et proportionnées visant à prévenir un risque de dommages graves et irréversibles à l'environnement à un coût économiquement acceptable »[1]. La France avait ajouté à la définition de Rio les notions de réaction proportionnée et de coût économiquement acceptable. Mais comment juger ce qui est acceptable si justement on n’a pas de certitude au sujet du mal à éviter ?

En février 2005, lorsque le président Chirac nous disait : « La maison brûle et nous regardons ailleurs », le Parlement réuni en congrès inscrivit dans la Constitution la Charte de l'environnement, installant par là- même le principe de précaution au niveau le plus élevé de la hiérarchie des normes juridiques :

"Proposition 5. Lorsque la réalisation d'un dommage, bien qu'incertaine en l'état des connaissances scientifiques, pourrait affecter de manière grave et irréversible l'environnement, les autorités publiques veilleront, par application du principe de précaution, et dans leurs domaines d'attribution, à la mise en œuvre de procédures d'évaluation des risques et à l'adoption de mesures provisoires et proportionnées afin de parer à la réalisation du dommage [2].

"

Même problème : comment évaluer ce qui est proportionné en se basant sur une prévision « bien qu’incertaine » ? Il faut alors évaluer le degré d’incertitude. Or assistons-nous vraiment à une évaluation collective du degré de certitude et d’incertitude de la menace climatique ?

Certitudes et incertitudes sur la menace climatique

Ce qui est certain :

a/ la réalité d’un réchauffement climatique depuis 150 ans, environ + 1°C ;

b/ le fait que l’industrie humaine extrait des énergies « fossiles » (charbon, pétrole, gaz) dont la combustion émet du CO2 ;

c/ le processus physique de l’effet de serre dont est capable notamment le CO2 (parmi les gaz dont les molécules possèdent une vibration électromagnétique capable de piéger le rayonnement infrarouge émanant de la terre).

Pas question de douter de ces trois faits. En revanche la question porte sur leur corrélation, autrement dit sur la thèse défendue par le GIEC depuis 30 ans[3]. Cette thèse affirme que les molécules de CO2 émises par l’activité humaine augmentent l’effet de serre, ce qui explique le réchauffement déjà effectif et surtout annonce un renforcement inéluctable de ce réchauffement dans des proportions (+6 °C) que la Terre n’a jamais connue et qui auront des conséquences fatales. Le « réchauffement climatique » n’est pas présenté comme une hypothèse mais comme un fait que seuls nos égoïsmes et notre inconscience nous empêchent de prendre en considération : les gens négligent d’y penser parce qu’ils ne veulent pas payer le prix qu’il faut pour sauver la Terre, soit environ 35 000 milliards d’euros (35 fois la dette de la France).

C’est donc une relation de causalité qui permet d’effectuer des prévisions. Qu’est-ce qu’une cause ? Un fait ou une théorie ? Et si c’est une théorie, comment en mesure-t-on la certitude ?

David Hume nous apprend qu’une conjonction ne prouve pas forcément une connexion : si le fait A arrive simultanément à B, cela ne prouve pas nécessairement que A soit la cause de B. La causalité ne se déduit pas a priori, donc en fait elle ne se démontre pas mais se fonde sur l’expérience des faits. Or les faits n’expriment pas de nécessité. Hume (Enquête sur l'entendement humain) :

"Le soleil ne se lèvera pas demain, cette proposition n'est pas moins intelligible et elle n'implique pas plus contradiction que l'affirmation : il se lèvera. Nous tenterions donc en vain d'en démontrer la fausseté. Si elle était démonstrativement fausse, elle impliquerait contradiction et l'esprit ne pourrait jamais la concevoir distinctement. C'est donc peut-être un sujet digne d'éveiller la curiosité que de rechercher quelle est la nature de cette évidence qui nous assure de la réalité d'une existence et d'un fait au-delà du témoignage actuel des sens ou des rapports de notre mémoire. [...]

Tous les raisonnements sur les faits paraissent se fonder sur la relation de la cause à l'effet. C'est au moyen de cette seule relation que nous dépassons l'évidence de notre mémoire et de nos sens. Si vous demandiez à quelqu'un pourquoi il croit à la réalité d'un fait qu'il ne constate pas effectivement, par exemple que son ami est à la campagne ou en France, il vous donnerait une raison ; cette raison serait un autre fait : une lettre qu'il a reçue ou la connaissance de ses résolutions antérieures et de ses promesses. [...]

La connaissance de cette relation ne s'obtient, en aucun cas, par des raisonnements a priori ; mais elle naît entièrement de l'expérience quand nous trouvons que des objets particuliers sont en conjonction constante l'un avec l'autre. Qu'on présente un objet à un homme dont la raison et les aptitudes soient, par nature, aussi fortes que possible ; si cet objet lui est entièrement nouveau, il sera incapable, à examiner avec la plus grande précision ses qualités sensibles, de découvrir l'une de ses causes ou l'un de ses effets.

"

Les projections informatiques du GIEC prolonge vers l’avenir la « conjonction » des faits a/, b/, c/. Mais sur quelle période cette conjonction a-t-elle été constatée ? L’image que nous avons tous des perspectives climatiques laisse-t-elle une place aux « incertitudes » ? Il semble que non (objet de la section II) et c’est pourquoi le prix à payer semble légitime. Et pourtant ces incertitudes sont importantes (sections III et IV).

II- Médias, peurs, images et vérité

On imaginera aisément que nous ayons tendance à minimiser les menaces environnementales afin de ne pas remettre en cause notre modèle industriel de développement. Comme une vérité qu’on refuse de regarder en face, une « vérité qui dérange » pour reprendre les mots d’Al Gore. Par intérêt, par insouciance, inconscience, négligence. Les faits sont assez nombreux et connus pour qu’il soit inutile de les développer ici : extinctions d’espèces, pollution de l’eau, de l’air, de la mer ; déboisements, etc.

Mais inversement nous sommes peut-être tentés de surévaluer cette menace. Pour d’autres raisons mais qui pèsent aussi : les progrès récents sont tellement fulgurants, ils changent tellement notre mode de vie que nous redoutons d’avoir à en payer le prix. L’écologie serait, en ce sens, une sorte de mauvaise conscience de la société industrielle.

La surinterprétation des conjonctions aléatoires

Les phénomènes météorologiques (notamment les plus extrêmes) sont aléatoires, imprévisibles : on peut évaluer leur fréquence statistique. Mais notre intelligence a tendance à imaginer une répartition régulière des faits aléatoires : du coup si un phénomène se reproduit plusieurs fois, on interprète cette répétition comme si elle était l'effet d'une causalité qu'il faudrait mettre en lumière. Il y a des catastrophes naturelles : il y en a toujours eu. À partir de quelle augmentation statistique peut-on dire qu'une répétition qu'on croyait aléatoire manifeste en fait une causalité ?

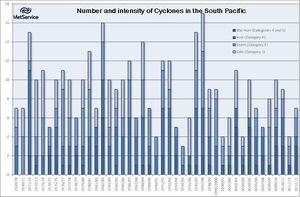

Ainsi, les phénomènes extrêmes sont systématiquement reliés au « dérèglement climatique » même quand on n'a aucune idée sur une hypothétique relation de causalité. Par exemple, tout le monde pense que le réchauffement multiplie les cyclones. Or les statistiques montrent presque le contraire sur les 30 dernières années (graphique ci-dessus à gauche, source : Meteorological Service of New Zealand Limited).

Exemples de paniques exagérées

La grande famine. En 1968, Paul Ehrlich écrivait : « Le combat pour nourrir l’humanité est presque perdu. Nous ne serons pas capables d’éviter une famine dans les dix prochaines années. » En 1974, il insistait : « La catastrophe alimentaire submergera probablement l’humanité dans les années 80. »

Le « pic pétrolier ». En 1980 il ne restait plus que 55 ans de réserves de pétrole. Pourtant en 2014, les réserves connues nous donnent encore… 125 ans de réserves.

Les victimes climatiques. En 2005 le directeur de l'Institut de l'environnement et de la sécurité humaine à l'ONU annonçait à Bonn qu'en 2010 il y aurait « 50 millions de réfugiés climatiques ».

La peur du grand refroidissement. En 1971, le fondateur de la revue Climate change alerte l’opinion : « Nos calculs suggèrent un refroidissement de 3,5 °C ». En 1975, l’Académie des sciences américaines confirme la prévision : « Le climat présente actuellement des symptômes alarmants. Il y a tout lieu de craindre que la Terre subisse un refroidissement dramatique des températures au cours de cent prochaines années » (G, P 61).

Revenons à notre sujet et partons de l’image emblématique du réchauffement : celle des ours polaires au bord de la noyade.

La disparition des ours blancs. « 2005 et 2006, le Groenland et le territoire autonome de Nunavut (population inuit du nord du Canada) ont officiellement demandé la possibilité d’accroître leurs quotas de chasse des ours blancs. Dans le cas de Nunavut, la demande concernait une hausse de 28 % et elle était justifiée par l’augmentation considérable des ours dans la région selon les témoignages de la population [4]. » Autre source : « La population totale a été estimée en 2006 entre 20 000 et 22 000 individus [5]. » En 2015, on relève une population de 20 000 à 25 000 individus. Soit probablement… un chiffre en hausse [6] .

Des images nous montrent les pauvres bêtes périssant noyées à cause de la fonte estivale de banquise : la une de Science et Vie junior (ci-contre) de septembre 2015 montre un ours polaire malheureux assis sur un petit morceau de banquise, portant une bouée de sauvetage, comme s’il risquait de se noyer en tombant à l’eau.

Or l’ours polaire est capable de nager 50 km d’une seule traite et « à la fin de l'été 2008, une femelle équipée d'un émetteur a parcouru (à la nage) la distance incroyable de 687 kilomètres en dix jours, en ayant perdu en tout 22% de son poids. Par la suite elle marchera encore 1800 kilomètres sur la glace[7]. »

Notre inconscient collectif les imagine se noyant à la fonte des glaces. Il paraît logique que les ours polaires souffrent d’une éventuelle détérioration de leur biotope. Mais un reportage d’Arte avoue qu’on ne sait pas grand-chose sur la population des ours blancs et donne la parole aux habitants du Grand Nord qui sont tous d’accord pour dire qu’ils en voient davantage[8]. Le reportage conclut pourtant : avec le réchauffement, ils vont disparaître dans 50 ans.

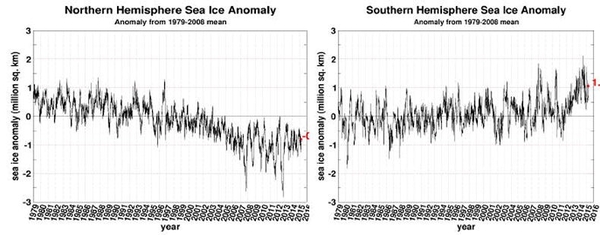

Cette conclusion contredit les témoignages et l’observation mais il est justifié par les modèles informatiques de projection du GIEC. Ainsi en 2006, le GIEC et Al Gore reçurent le prix Nobel de la paix à cause de leurs alertes sur le global warming. Al Gore, dans Une vérité qui dérange prédisait la disparition estivale de la banquise arctique à l’horizon 2013. Or non seulement elle ne disparut pas cet été-là, mais entre 2012 et 2013 ce qui restait de la banquise après les fontes estivales a augmenté de 50 % [9] tandis que les glaces antarctiques sont en constante augmentation depuis 1978 et en mai 2015 le froid a battu un record : -80,1°C avec une moyenne exceptionnelle de -70 contre - 64 en temps normal…

Un changement sémantique est ici notable : on ne parle plus de « réchauffement climatique » mais de « changement climatique » ce qui ne veut rien dire puisque le climat est changeant par nature.

La peur écologique n’est pas seulement une angoisse de toute puissance, elle en est aussi une expression. Le GIEC semble attribuer à l’homme le pouvoir de changer ou non le climat, comme si, devant nous, la puissance industrielle faisait apparaître un thermostat global que nous pourrions décider de monter de 1, 2 ou 5°C suivant les sacrifices que nous serions capables de consentir pour contenir cette augmentation.

Finalement l’écologie exprime autant notre toute puissance que notre dépendance. Et les passions nous inclinent tout autant à minimiser les risques, par intérêt, qu’à les exagérer, par l’effet d’une fascination apeurée envers notre propre pouvoir.

Que nous dit la raison face aux risques écologiques ?

Sur l’évolution des deux banquises, les images satellites montrent une baisse sensible pour l’Arctique de 1979 jusqu’en 2012, puis une remontée brusque en 2013 et une stabilisation avec même une légère reprise. Reste qu’en 35 ans, l’Arctique a perdu un million de km2 de banquise. Mais dans l’hémisphère sud la banquise a augmenté presque d’autant…

Source : Cryosphere Today, Arctic Climate Research, University of Illinois.

Plus généralement, voici ce que déclarait la climatologue Judith Curry en mai 2015 à la Chambre des Représentants des États-Unis [10] :

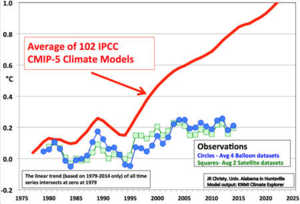

"Le taux de réchauffement durant les 15 dernières années (1998-2012) est de 0.05 [de –0.05 à +0.15] °C par décennie, ce qui est inférieur au taux calculé depuis 1951 qui est 0.12 [de 0.08 à 0.14]°C par décennie. [...] Les médias ont promu l'idée que 2014 était “l'année la plus chaude” des données historiques, mais, étant données les incertitudes, 2014 était statistiquement indiscernable de 2010 et 2005. Les données du HadCRU [11] qui sont peut-être les plus réalistes du point de vue des incertitudes, ont montré que 2014 se classait parmi les dix années les plus chaudes qui ont toutes eu lieu depuis 1998. Bien que la dernière décennie ait été la plus chaude de l'histoire, les données pour l'année la plus chaude ne font que prolonger le plateau du réchauffement. Ainsi, constations nous que nous n'avons pas observé de hausse de température depuis 1998 alors que cette période a connu une augmentation égale à 25% du total des émissions de CO2 anthropiques.

Ce hiatus contredit les conclusions du rapport AR4 (2007) du GIEC qui avait prévu un réchauffement avec un taux de 0.2°C par décennie au début du xxie siècle. Un grand nombre d'articles scientifiques ont mis en lumière l'importance de la variabilité naturelle associée avec la circulation dans les océans Pacifique et Atlantique dont on pense, à présent, qu'ils sont la cause principale du hiatus. Si le hiatus récent du réchauffement résulte de la variabilité naturelle, alors ceci pose la question de savoir dans quelle mesure le réchauffement qui s'est produit entre 1975 et 1998 peut être, lui aussi, expliqué par la variabilité naturelle du climat.

"

Le schéma (ci-contre, à gauche) qui montre le hiatus dont parle Judith Curry : la différence entre les prévisions du GIEC (IPCC) et les données observées (Source : JR Christy, University of Alabama).

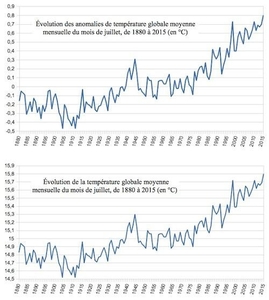

Une même donnée peut être représentée de façons bien différentes (ci-contre à droite, source : NOAA, comparaison des anomalies sur les températures au mois de juillet 2015).

Ici la courbe très anxiogène montre une progression vertigineuse des « anomalies » : mais en fait ces anomalies sont relatives à une moyenne (niveau noté 0). Sur quelle période s'établit cette moyenne ? Pourquoi celle-ci ? Pourquoi pas une autre période ?

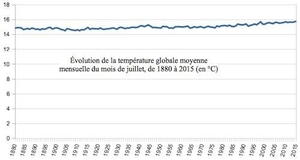

Les mêmes données mais cette fois sous la forme de moyenne, et à l'échelle. La différence est assez nette :

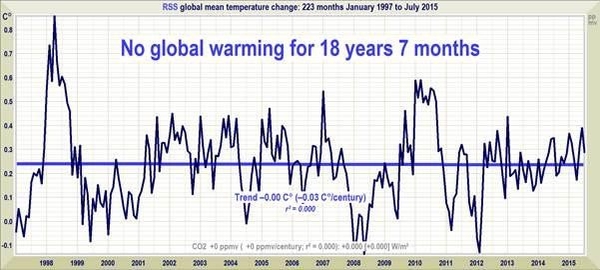

Enfin sur les 18 dernières années, voici les données prises par satellite :

Source : Christopher Monckton, Climatedepot.com.

Sans commentaires !

Pierre Labrousse est professeur agrégé de philosophie.

Prochain article :

D’autres scénarios sur l’évolution du climat

_____________________________

[1]. Loi no 95-101 du 2 février 1995 relative au renforcement de la protection de l'environnement. Texte en italique souligné par nous.

[2]. Passages en italique souligné par nous.

[3]. GIEC : Groupe d'experts intergouvernemental sur l'évolution du climat, en anglais IPCC- Intergovernmental Panel on Climate Change.

[4]. http://climat-sceptique.over-blog.com/article-2686820.html

[5]. http://www.ourspolaire.org/l-ours-polaire/tout-sur-lours-polaire/populations/

[6]. http://www.svalbard.fr/nouvelle-polaire/Comptage-ours-blancs-Arctique-2015_02.htm

[7]. http://www.svalbard.fr/nouvelles-polaires/2011_06.htm

[8]. http://future.arte.tv/fr/ours-polaire

[9]. http://dailycaller.com/2015/01/05/arctic-sea-ice-a-whole-lot-more-stable-than-scientists-al-gore-predicted/

[10]. https://curryja.files.wordpress.com/2015/04/house-science-testimony-apr-15-final.pdf

[11]. Base de données climatiques de référence, établie par le UK Met Office Hadley Centre et l’University of East Anglia Climate Research Unit.